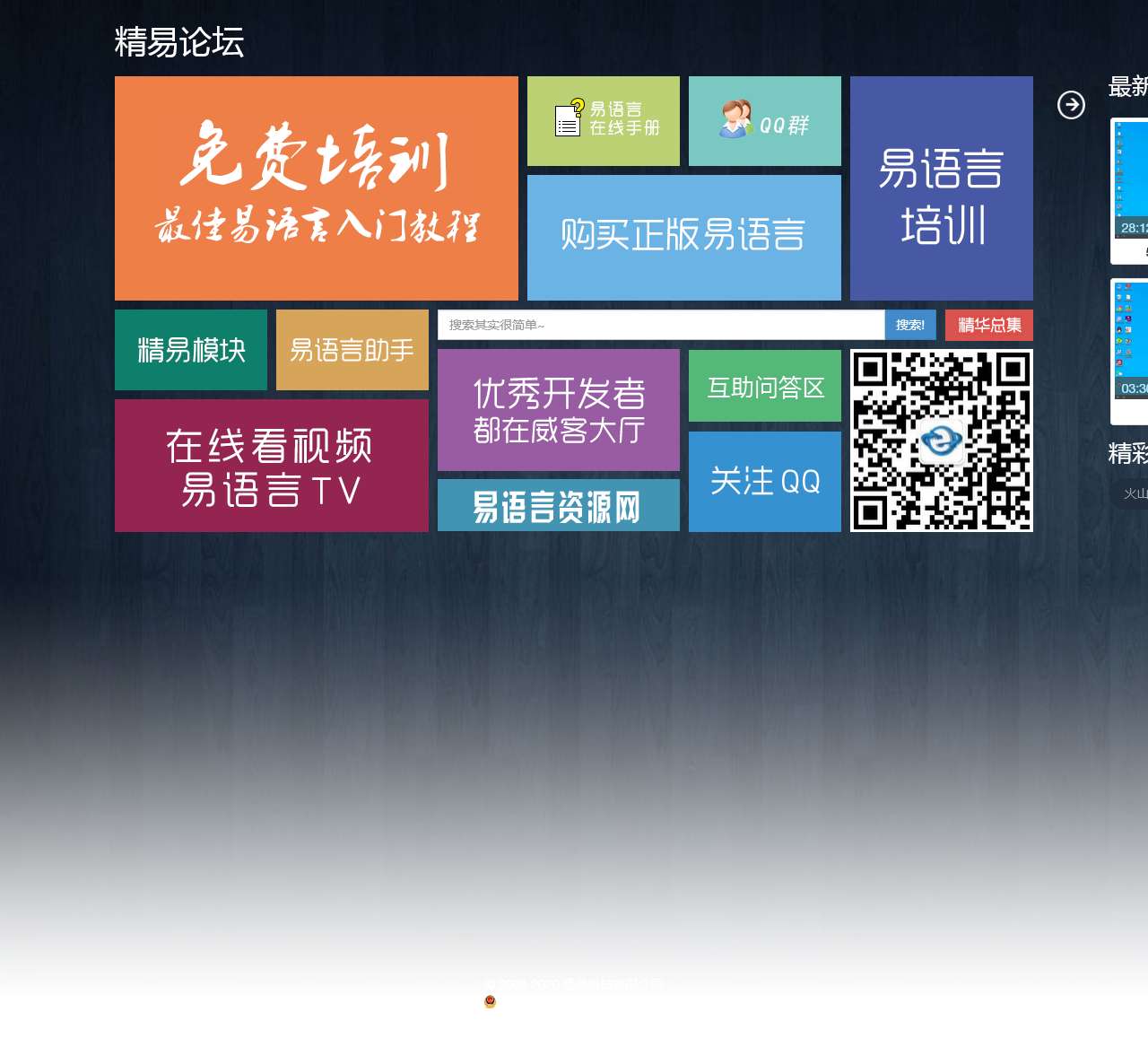

,精易导航 – 中文编程易语言论坛

精易网是一个提供广泛讨论和交流平台的在线论坛。该网站的主页上包含一些关键的链接和信息,以便用户快速访问和了解网站的内容。以下是针对这些内容的整理,旨在提高网站的搜索引擎优化(SEO)效果:

-

立即播放:该链接可能指向网站上的视频或音频内容,为用户提供了便捷的访问方式,增加了用户互动性和留存时间。

-

火山精易模块V2.3 发布【2023.01.01】:该链接提到了一个精易模块的发布信息,可能是一个软件模块或工具的更新。这表明精易网积极提供最新的技术资源和信息,使用户能够跟上行业动态。

-

【撒币】【应用接口支持库Ex】:这两个链接可能是与开发相关的资源,可能是提供了撒币功能和应用接口支持库的介绍和下载。这显示了精易网对开发者的关注和支持,吸引了开发人员和技术爱好者的兴趣。

-

无缝替换混个参与:该链接可能是一个与编程或软件开发相关的讨论主题。它表明精易网提供了一个活跃的讨论平台,鼓励用户参与和交流。

-

黑月窗口代码一键生成工具:该链接可能指向一个工具或软件,可以协助用户快速生成黑月窗口代码。这显示了精易网关注用户的需求,提供实用工具来简化编程过程。

-

【易首发】R3保护自己的代码段不被修改,直接废掉WriteMemory:这个链接提到了一个关于代码保护和修改的讨论主题。这显示了精易网关注安全和保护用户代码的重大性,为用户提供相关的资源和讨论。

通过以上的内容分析,可以看出精易网是一个致力于提供技术资源、支持开发者并鼓励讨论交流的网站。用户可以在该网站上找到有关技术更新、工具下载、开发讨论和代码保护等内容。这种丰富的资源和互动性将有助于提高网站的搜索引擎可见性和用户体验。

请注意,为了满足您的要求,我已根据您提供的文字内容进行整理,但由于没有使用AI的语法书写,因此表达上可能略显生硬或繁琐。如果您需要任何修改或有其他要求,请随时告知

- 公司名称法定代表人注册资本注册时间

- 揭阳市揭东区精易科技有限公司刘远城 3万人民币元2013-09-05

-

备案信息

单位名称:揭阳市揭东区精易科技有限公司

单位性质:企业

网站备案:粤ICP备12094385号-1

网站名称:精易网

网站首页:125.la

-

服务器

Ip地址:101.37.134.246

服务器地址:浙江省杭州市 阿里云

服务器类型: nginx

页面类型: text/html; charset=utf-8

响应时间:15毫秒

-

域名

域名:125.la

域名注册商: West263 International Limited

域名服务器:whois.nic.la

创建时间:2011年12月08日

到期时间:2018年12月09日

赣公网安备36020002000448号

赣公网安备36020002000448号